Desarranjo cerebral

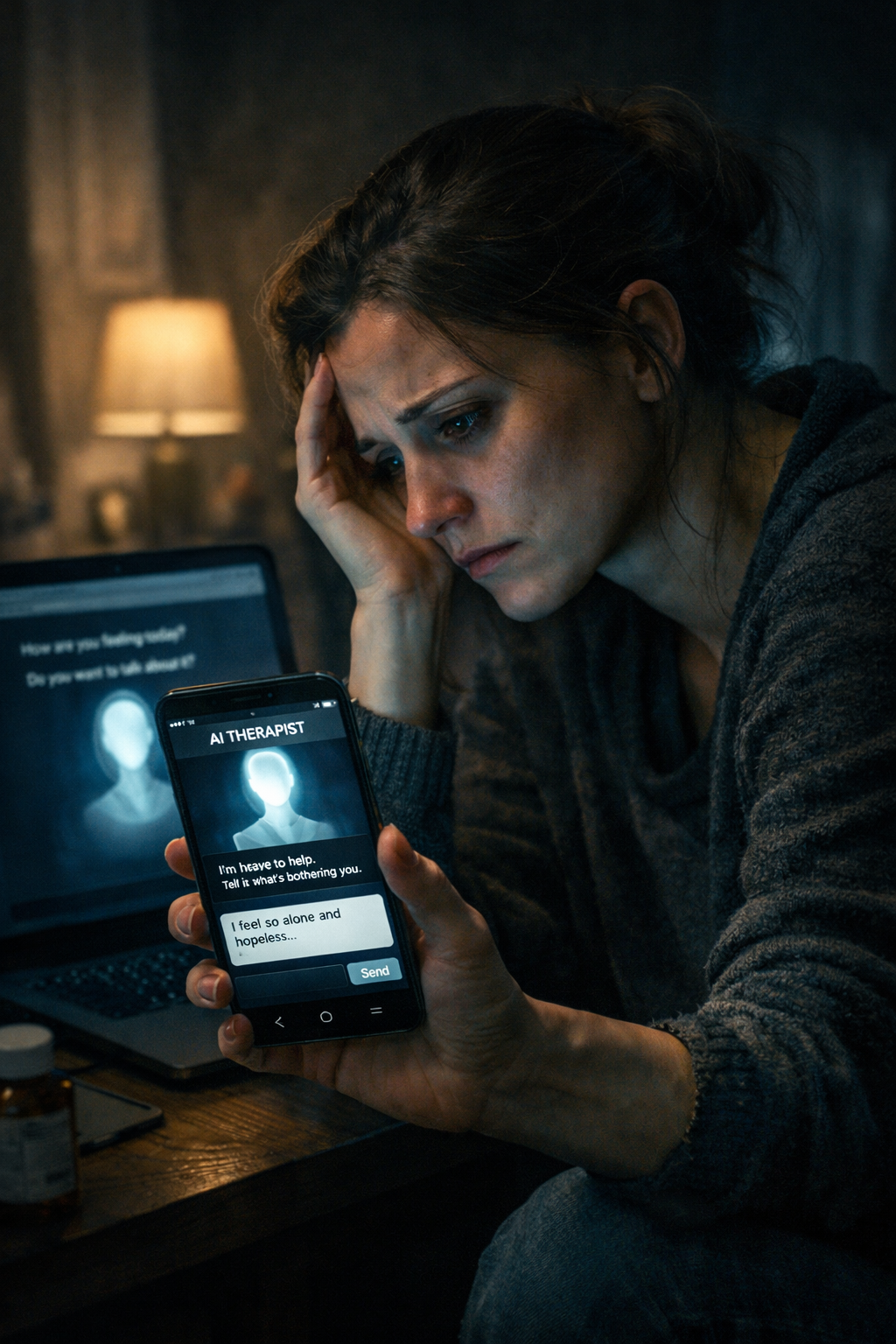

Uso da I.A. na psiquiatria pode criar autoterapia

Publicado

em

O avanço vertiginoso da inteligência artificial na área da saúde tem sido celebrado como promessa de democratização do cuidado, redução de custos e ampliação do acesso a diagnósticos. Na psiquiatria, porém, esse entusiasmo começa a acender um sinal vermelho. Cientistas, pesquisadores em saúde mental e especialistas em ética digital alertam: o uso indiscriminado de sistemas de I.A. para “aconselhamento emocional” pode desencadear uma perigosa onda de autoterapia, com riscos profundos e, em alguns casos, irreversíveis.

Aplicativos, chatbots e plataformas treinadas para simular escuta empática vêm sendo utilizados como substitutos — e não apenas complementos — do acompanhamento profissional. O problema não está na tecnologia em si, mas na ilusão de neutralidade e segurança que ela projeta. Algoritmos não possuem consciência, responsabilidade clínica nem capacidade real de compreender a complexidade do sofrimento psíquico humano.

Pesquisadores apontam que modelos de linguagem tendem a reforçar narrativas internas do usuário, funcionando como espelhos sofisticados. Em pessoas vulneráveis, isso pode consolidar crenças distorcidas, validar sintomas sem o devido contraditório clínico e até normalizar ideias autodestrutivas. Diferentemente de um psiquiatra ou psicólogo, a I.A. não identifica silêncios, contradições sutis, linguagem corporal ou mudanças de humor — elementos centrais da prática terapêutica.

Outro risco recorrente é a confusão entre acolhimento e tratamento. Ao oferecer respostas bem articuladas e aparentemente empáticas, sistemas automatizados induzem o usuário a acreditar que está sendo tratado. Na prática, isso pode retardar a busca por ajuda profissional, agravando quadros de depressão, transtornos de ansiedade, bipolaridade ou psicoses incipientes.

Há ainda um vácuo regulatório preocupante. Quem responde por danos causados por uma orientação inadequada de um sistema automatizado? A empresa desenvolvedora? O programador? O próprio usuário? Para cientistas da área, a ausência de marcos legais claros transforma a saúde mental em campo de experimentação de alto risco, onde o erro não custa dinheiro — custa vidas.

Além disso, o uso de dados sensíveis em interações psiquiátricas levanta dúvidas sobre privacidade, armazenamento e possível exploração comercial do sofrimento humano. Emoções, traumas e fragilidades viram insumo estatístico.

O consenso emergente entre pesquisadores é claro: a inteligência artificial pode ser ferramenta auxiliar — jamais terapeuta. Pode ajudar na triagem, no monitoramento de padrões, no apoio administrativo e até na ampliação do acesso inicial ao sistema de saúde. O que não pode é ocupar o lugar do vínculo humano, da escuta qualificada e da responsabilidade clínica.

Transformar a I.A. em psiquiatra de bolso pode parecer solução moderna para um mundo ansioso e solitário. Mas, como alertam cientistas, trata-se de uma modernidade enganosa — capaz de anestesiar o sofrimento sem tratá-lo, aprofundando o isolamento em vez de curá-lo.

Para psiquiatras, particularmente, quando se trata de saúde mental, atalhos tecnológicos não substituem o caminho delicado, humano e insubstituível do cuidado de um profissional da área.